编辑:蛋酱、小舟

这份 189 页的博士学位论文,凝结了尤洋在快速机器学习训练算法领域的研究心血。

过去十年,深度学习应用领域的数据量迅速增长,使得深度神经网络(DNN)的训练时间拉长。而这已经成为机器学习开发者和研究者面临的瓶颈问题。例如,在 8 个 P100 GPU 上完成 90 个 epoch 的 ImageNet/ResNet-50 训练需要 29 个小时,在 16 个 v3 TPU 芯片上完成 BERT 预训练需要 81 个小时。

因此,如何有效缩短机器学习训练时间,同时完成高质量的训练,对于解决当前的瓶颈问题具有重大意义。

本文将介绍一篇长达 189 页的博士学位论文,作者为加州大学伯克利分校计算机系的尤洋博士。

尤洋的主要研究方向是高性能计算与机器学习的交叉领域,当前研究重点为大规模深度学习训练算法的分布式优化。他曾创造 ImageNet 训练速度的世界纪录,相关研究成果被 Google、Facebook、腾讯等科技巨头在实际中使用。

尤洋曾以一作的身份获得 2018 年国际并行处理大会(ICPP)最佳论文奖,论文《Imagenet training in minutes》所提出的方法刷新了 ImageNet 训练速度的世界纪录。

去年,尤洋和来自谷歌和 UCLA 的研究者共同提出了一种用于加速大批量训练的新型优化器 LAMB,将基线 BERT-Large 模型的预训练时间从 3 天降低到了 76 分钟。

此外,尤洋还获得过国际并行与分布式处理大会(IPDPS)2015 的最佳论文奖。他还曾在 IBM 沃森研究中心、英特尔总部、英伟达总部、微软总部以及谷歌总部实习。

今年 7 月,尤洋从加州大学伯克利分校毕业,获得计算机科学博士学位。目前已入职新加坡国立大学计算机系任助理教授(终身制)。近日,他在社交媒体上介绍了自己的博士论文。

尤洋在推特上介绍自己的博士论文(照片拍摄于疫情前)。

论文链接:https://www2.eecs.berkeley.edu/Pubs/TechRpts/2020/EECS-2020-136.pdf

接下来,我们将简要介绍这篇博士论文的核心内容,感兴趣的读者可以阅读原论文。

论文核心内容简介

这篇论文聚焦于快速且准确的机器学习训练。尽管生产团队希望能够充分利用超级计算机来加快训练过程,但传统的优化器无法扩展到数千个处理器。该研究设计了一系列基础优化算法,来为深度学习系统实现更强的并行度。这些算法为谷歌、英特尔、腾讯、英伟达等公司的 SOTA 分布式系统提供了支持。

这篇论文的重点是缩小高性能计算(HPC)和机器学习(ML)之间的差距。

2017 年,HPC 和 ML 之间存在着巨大的差距。一方面,功能强大的超级计算机已经出现,每秒可执行 2 × 1017 次浮点运算。但另一方面,我们却无法充分运用此算力的 1% 来训练 SOTA 机器学习模型。原因是超级计算机需要极高的并行度才能达到峰值性能。但是,高度的并行会导致 ML 优化器的收敛性很差。

为了解决这个问题,尤洋及合作者提出了 LARS 优化器、LAMB 优化器以及 CA-SVM 框架,缩小了机器学习与分布式系统之间的差距。

论文结构

这篇论文的主要贡献是:「在增加并行度的同时,根据需要改动算法,从而通过避免通信来保持效率。」为了做到这一点,研究者需要根据需求改动算法和 / 或超参数,或使用不同的近似解来维持准确率。

该论文包括以下三个主要部分:

第二章详细讲解了通信避免的 SVM(communication-avoiding SVM),第三章详细介绍了通信高效的 KRR(communication-efficient KRR),第四章详细介绍了异步贪心坐标下降(Asy-GCD)。

第五章介绍了在超级计算机上加速 ImageNet 训练的细节,包括算法设计和通信 / 计算权衡。

第六章介绍了将 BERT 训练时间从 3 天降低到 76 分钟的技术细节,这是建立在大批量优化和超参数自动调整等技术之上的。

这三个部分紧密相关。研究者在第一部分中以凸优化开始,在第二部分中深入探讨非凸优化。由于非凸优化比凸优化要难得多,因此作者在第三部分中又进行了详细介绍。第七章则进行了总结。

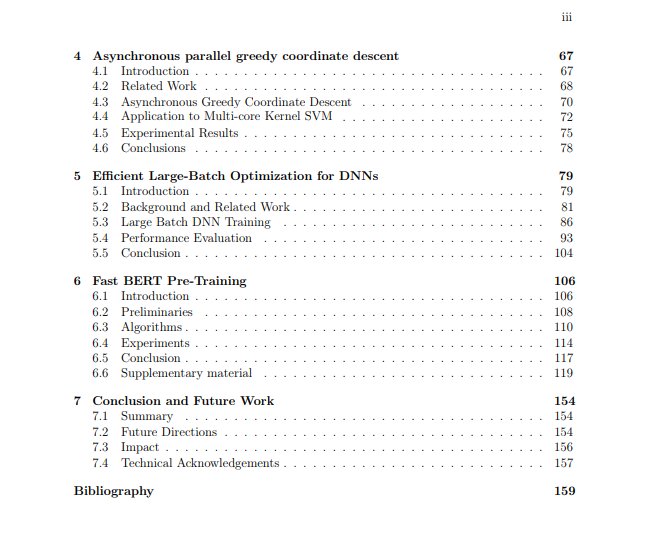

以下是这篇博士论文的目录:

在论文的致谢部分,尤洋首先感谢了导师 James Demmel(Jim):「在波士顿,我参加了第一场学术会议 IPDPS 2013,Jim 是那次会议的主题演讲者。我对 Jim 优秀的人格和领导才能印象深刻。也就是在那个时候,我想要成为一名博士,成为 Jim 的学生。…… 在 Jim 的指导下,我在过去的五年里完成了 13 篇论文,Jim 会花好几个小时修改我每一篇论文草稿。Jim 是个很好的人,他给了我很多自由和必要的指导。我很感激他花时间来审视我的职业目标,并给出实现这些目标的策略。毫无疑问,对我学术生涯影响最深的人是 Jim,我今后的人生也将受到他的深刻影响。」

James Demmel 是加州大学伯克利分校电子工程与计算机科学系主任,Dr. Richard Carl Dehmel 杰出教授,因在数值线性计算库 LAPACK 方面的贡献而为人熟知。此外,他还是 ACM Fellow、IEEE Fellow,美国艺术与科学院、美国国家工程院、美国国家科学院三院院士。

在致谢的最后,尤洋表达了对家人的感谢:

最后,我想感谢我的母亲 Yanlei Huang,父亲 Zhiqiang You,兄长 Peng You,以及我的妻子 Shiyue Liang。我将向家人们表达最深的感谢,没有他们无条件的支持我不可能获得今天的成就。我会一直在你们身边。

Amazon SageMaker 是一项完全托管的服务,可以帮助开发人员和数据科学家快速构建、训练和部署机器学习 模型。SageMaker完全消除了机器学习过程中每个步骤的繁重工作,让开发高质量模型变得更加轻松。

现在,企业开发者可以免费领取1000元服务抵扣券,轻松上手Amazon SageMaker,快速体验5个人工智能应用实例。

“掌”握科技鲜闻 (微信搜索techsina或扫描左侧二维码关注)